Экскурсия в облако: фотографии из дата-центра (ЦОД), где размещены облачные серверы «Максиплэйс»

Что вы увидите, если пройдётесь по дата-центру с фотокамерой? Мы попросили нашего инженера сделать несколько фотографий во время планового визита в московский ЦОД, где размещены облачные серверы наших клиентов, и объяснить, чем обеспечивается его надёжность.

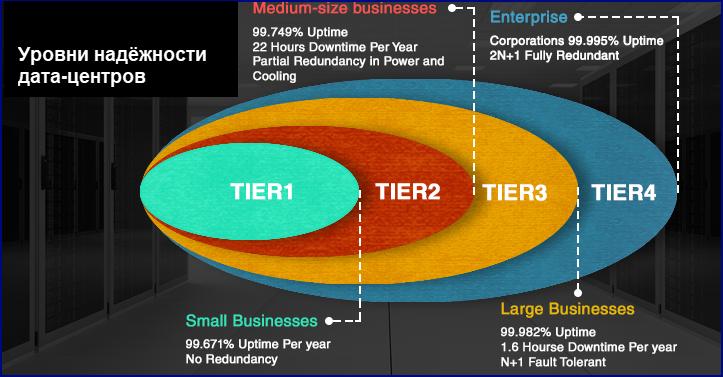

Уровни надёжности дата-центров. Почему выбирают Tier 3?

Американская организация Uptime Institute, объединяющая экспертов по дата-центрам, сформулировала концепцию четырёх уровней надёжности.

Эти уровни (tiers) соответствуют тому, насколько инфраструктура ЦОД способна обеспечивать бесперебойную работу при проведении плановых ремонтов, а также в критических ситуациях – при отключении электроэнергии, сбоях оборудования, возгорании, перепаде погодных условий или стихийных бедствиях.

Каждый следующий уровень включает возможности предыдущего.

Рассмотрим ключевые отличия между этими уровнями.

Дата-центр первого уровня (Tier 1)

-

Не оборудован резервным питанием и вентиляцией, а если и оборудован, то по минимуму. Поэтому во время ремонтных или профилактических работ серверное оборудование приходится отключать.

-

Допустимый простой серверов – не более 28,8 часов в год.

-

Подходит для некритичных задач малого бизнеса.

Дата-центр второго уровня (Tier 2)

-

Имеет один канал электропитания и охлаждения, но с резервированными компонентами. Для некоторых ремонтных работ всё равно необходимо отключение серверов. Должен быть оснащён ИБП и дизель-генератором.

-

Допустимый простой серверов – не более 22 часов в год.

-

Подходит для некритичных задач среднего бизнеса.

Дата-центр третьего уровня (Tier 3)

-

Имеет несколько каналов электропитания и охлаждения (рабочие и резервные), из которых активен только один. Поэтому плановые профилактические работы можно проводить без остановки операций.

-

Допустимый простой – не более 1,6 часов в год (8 минут в месяц).

-

Подходит для крупного бизнеса и государственных организаций с повышенными требованиями к непрерывности операций и защищённости данных.

Облачные сервера “Максиплэйс” размещены в дата-центре, соответствующем всем требованиям уровня Tier 3.

Дата-центр четвёртого уровня (Tier 4)

-

Имеет двойное резервирование всех подсистем по принципу 2(N+1), где N это необходимое количество единиц оборудования для нормальной работы. То есть, если для работы требуется, скажем, 5 ИБП, то в дата-центре четвёртого уровня их должно быть не менее 12. Поэтому предполагается, что такой дата-центр способен продолжать операции как при плановой профилактике, так и при незапланированных инцидентах.

-

Допустимое время простоя – не более 26,3 минут в год (2 минуты в месяц).

-

Очень дорогой в строительстве и эксплуатации, поэтому рекомендуется использовать только для критически важных задач.

Если сравнить характеристики по уровням, то наибольший прирост по надёжности (гарантированный % времени uptime) мы получим при переходе с Tier 2 на Tier 3. Допустимое время простоя при этом сократится с 22 часов до 1,6 часа в год.

Если же рассматривать дальнейший переход на Tier 4, то при незначительном увеличении надёжности дата-центра стоимость его строительства и эксплуатации из-за требований двойного резервирования вырастет примерно вдвое. При этом увеличатся и цены для клиентов, которым придётся переплачивать за небольшой прирост по надёжности. Поэтому дата-центры уровня Tier 3 на данный момент являются оптимальным выбором для большинства коммерческих и государственных предприятий.

Посмотрим теперь, как выглядит такой дата-центр изнутри.

Чем обеспечивается надёжность дата-центра. Фотографии.

Для размещения облачных серверов мы используем несколько дата-центров в Москве и за рубежом.

Наш основной московский ЦОД – это DataHouse, который находится на юге Москвы, в промзоне недалеко от станции метро “Нагорная”.

В семи залах дата-центра расположены 475 серверных стоек. В залах предусмотрены по два независимых выхода, а контур помещения изолирован и защищен от протечек.

Холодные и горячие коридоры

Холодный коридор в одном из серверных залов: через решётчатый пол поступает холодный воздух.

Между серверными стойками дата-центра расположены холодный и горячий коридоры. В холодный коридор снизу через решётчатый пол поступает охлаждённый воздух, а из горячего коридора, куда развёрнуты тыльные стороны стоек, разогретый воздух уходит в систему вентиляции.

Тыльная сторона серверных стоек выходит в горячий коридор. Его пол покрыт плитками без отверстий.

В каждой стойке установлено по шесть блоков распределения питания PDU Rittal с семью розетками в каждом.

На каждую стойку запроектирована мощность до 12 киловатт. Все стойки подключены к автоматам в энергетической щитовой с защитой от перегрузок и короткого замыкания.

По периметру холодного и горячего коридора находятся датчики температуры. Система мониторинга собирает поступающие с них данные и направляет в общую систему контроля службы эксплуатации ЦОД.

Энергоснабжение дата-центра идёт с нескольких независимых городских подстанций

Поскольку это бывший дата-центр Яндекса, он тщательно спроектирован под требования бесперебойного функционирования даже в случае отключения электричества.

В каждом зале есть независимая энергетическая щитовая комната.

По энергетике также обеспечено резервирование.

Переключатели основного и резервного энергетических контуров.

В дата-центре предусмотрены рабочий и резервный энергетические контуры. При аварии или плановых работах на одном из них дата-центр будет переключён на другой контур и продолжит работу.

Бесперебойные операции также обеспечивают ИБП, установленные по схеме N+1, то есть, с дополнительным резервным модулем.

Источники бесперебойного питания обеспечат работу ЦОД в случае аварии.

На каждый зал предусмотрена отдельная дизель-генераторная установка (ДГУ).

Дизель-генераторная установка обеспечит автономную работу оборудования до 12 часов в случае перебоев электроэнергии.

Если вдруг на городских подстанциях пропадёт электричество, дата-центр продолжит работать автономно за счёт ИБП и аккумуляторных батарей в течение получаса.

Аккумуляторные батареи поддержат работу дата-центра, если пропадёт электричество.

За это время запустятся дизель-генераторы, которые выйдут на необходимую мощность за 1-2 минуты. На дизель-генераторах дата-центр способен автономно работать до 12 часов, а если потребуется, то и дольше – с подачей топлива из отдельного резервуара.

Автоматическая противопожарная система

Если дымовые датчики, расположенные под фальшполом и над фальшпотолком, заметят возгорание, включается сирена, призывающая всех эвакуироваться. После этого автоматически начнется подача газа для устранения огня.

Система пожаротушения связана с системами охлаждения, чтобы автоматически отключить кондиционеры в случае пожара.

Газ Хладон-227 начнёт поступать автоматически, если датчики обнаружат возгорание.

Для тушения возгораний применяется газ Хладон-227. Его действие тормозит химическую реакцию горения, поэтому в присутствии газа горение становится невозможным. Хладон безопасен для использования в помещениях, где бывают люди, и не оставляет следов на оборудовании.

Система охлаждения с резервированием

В дата-центре, где размещены наши сервера, реализованы два типа охлаждения: прецизионное и чиллерное.

В двух машинных залах охлаждение холодного коридора с нижней подачей воздуха идёт за счет прецизионных кондиционеров. В каждом из них установлено 10 кондиционеров со схемой резерва 2N. В энергетической щитовой работают 4 машины со схемой резервирования N+1.

На улице рядом со зданием дата-центра установлены резервные дизель-генераторы. Они обеспечат работу машинных залов даже при длительном отсутствии питания с подстанций.

В остальных пяти залах и энергетических щитовых воздух подается в холодный изолированный коридор с верхнего технического этажа. Охлаждение обеспечивает система чиллерного охлаждения с двойным контуром.

Система чиллерного охлаждения с двойным контуром поддерживает в машинных залах нужную температуру – 21 градус Цельсия.

C крыши здания, где установлены вентиляторы системы охлаждения, открывается прекрасный вид на Москву.

Таким образом, дата-центр, в котором размещены наши облачные сервера, хорошо защищён от всех основных рисков – перебоев с электропитанием, затоплений, пожаров. Работа серверного оборудования длительное время без перегрева обеспечивается системой охлаждения с двойным контуром.

Благодаря резервированию и дублированию подсистем, дата-центр обеспечивает надёжность уровня Tier 3, в соответствии с которым годовой простой ЦОД не превышает 1,6 часа, а коэффициент отказоустойчивости составляет 99,98%.

Но, как показывает международный опыт, аварии случаются и по самым неожиданным причинам.

Резервный ЦОД как дополнительная гарантия сохранности данных

Несмотря на все меры, чтобы дата-центры работали бесперебойно, форс-мажоры случаются – и за рубежом, и в нашей стране.

В дата-центры врывается полиция, по ним ударяют молнии, случаются сбои оборудования и курьёзные ситуации (например, в Техасе внедорожник влетел в трансформаторную будку дата-центра), которые невозможно предусмотреть.

В статье про 10 эпических аварий и отключений в дата-центрах журнал “Компьютерра” рассказывает о вызвавших их причинах:

-

Дата-центр CyberBunker взяла штурмом немецкая полиция за нелегальный хостинг. Еще один дата-центр – Moonwalk в Нидерландах – прикрыли в октябре 2019-го за нарушение авторских прав на видеоконтент.

-

В июне 2019-го случился пожар в московском дата-центре OST (DataLine) на Боровой улице, который считался одним из самых надёжных в России.

-

В сентябре 2018 года сразу несколько дата-центров Microsoft в Техасе оказались в середине урагана. Удары молний привели к перебоям в электропитании и вызвали сбои в работе, которые длились несколько дней.

-

В августе 2018-го из-за сбоя в работе дата-центра «Ростелекома» начались проблемы у Росреестра. В результате в 50 регионах РФ были заморожены сделки с недвижимостью. К штатному режиму работы ведомство смогло вернуться только через две недели. Теперь данные Росреестра одновременно хранятся в трех дата-центрах.

Поскольку стопроцентно надежных дата-центров не бывает, самый действенный способ защиты своих данных — регулярные бэкапы. При этом хорошим вариантом будет хранение рабочих данных и их резервной копии в нескольких, географически удалённых дата-центрах.

В этом отношении мы тоже можем оказаться полезными. Кроме московских дата-центров, мы сотрудничаем с ЦОД в Европе и можем настроить автоматическое резервное копирование ваших данных в зарубежный ЦОД.

А если вы ещё не пользуетесь облачными сервисами, можно подключить услугу “Резервный ЦОД” и данные с ваших корпоративных серверов будут регулярно сохраняться в облако в защищённом дата-центре.Надеемся, этот материал был для вас полезным. Пусть с вашими данными всё будет в порядке.

Если у вас будут вопросы, комментарии или дополнения – пишите. С удовольствием ответим.

Статья добавлена 3 года назад. Автор - Eltigro